Šta su RNN i LSTM?

Četvrtak, 20. novembar 2025. 02:00

Autor: Dragan Tanaskoski

Tagovi: RNN, LSTM

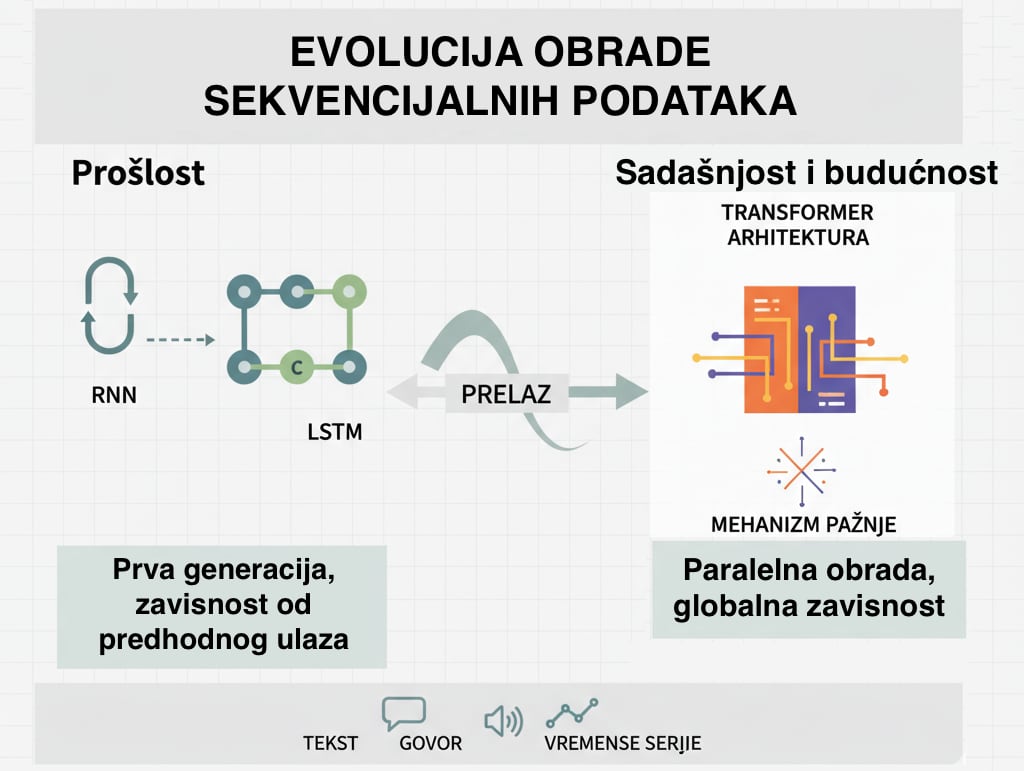

Pre nego što je Transformer arhitektura (i Mehanizam pažnje) preuzela primat, problem obrade sekvencijalnih podataka – kao što su tekst, govor ili vremenske serije – rešavali su Rekurentne Neuronske Mreže (RNN).

RNN i LSTM predstavljaju prvu generaciju modela koji su mogli da obrađuju sekvence, rešavajući problem da se izlaz u datom trenutku ne sme oslanjati samo na trenutni ulaz, već i na prethodne ulaze.

1. Rekurentne Neuronske Mreže (RNN)

Rekurentna Neuronska Mreža (RNN) je tip neuronske mreže koja ima petlju. Ova petlja omogućava da se informacija iz prethodnog koraka (prethodno obrađenog tokena) vrati i utiče na obradu trenutnog ulaza.

- Petlja i Memorija: U RNN-u, svaki korak obrade (npr. obrada jedne reči) koristi ne samo ulaznu reč, već i tzv. skriveno stanje (Hidden State) iz prethodnog koraka. Ovo skriveno stanje služi kao kratkoročna "memorija" mreže.

- Sekvencijalna Priroda: RNN obrađuje podatke striktno korak-po-korak. Ne može da obrađuje celu rečenicu odjednom.

Glavni problem: Gubitak duge memorije

Iako su RNN modeli bili revolucionarni, patili su od fundamentalnog problema: Problem nestajućih gradijenata (Vanishing Gradients).

Što je sekvenca duža (što je rečenica duža), informacije sa početka rečenice postepeno blede i postaju nebitne do trenutka kada model dođe do kraja. Model je efektivno zaboravljao kontekst koji se dogodio pre mnogo koraka. Ovo je otežavalo složeno razumevanje dugačkih tekstova.

2. LSTM (Long Short-Term Memory)

Da bi rešili problem gubitka konteksta kod RNN-a, razvijene su LSTM (Long Short-Term Memory) mreže.

LSTM je specijalizovani tip RNN-a koji je dizajniran da efikasno uči i pamti dugoročne zavisnosti.

Ključna inovacija u LSTM-u je uvođenje složenije strukture unutar svakog rekurentnog modula, poznatog kao Ćelija (Cell). Ova ćelija ima tri glavna kontrolna mehanizma, ili tzv. kapije (eng. Gates):

- Kapija za zaboravljanje (eng. Forget Gate): Odlučuje koju informaciju iz starog stanja ćelije treba odbaciti (zaboraviti), jer je više nije relevantna.

- Kapija za ulaz (Input Gate): Odlučuje koju novu informaciju treba upisati (naučiti) iz trenutnog ulaza.

- Kapija za izlaz (Output Gate): Odlučuje koji deo konačnog stanja ćelije treba izložiti kao skriveno stanje za sledeći korak.

Ključna prednost

Kroz ove kapije, LSTM može da selektivno ažurira svoju dugoročnu memoriju, omogućavajući mu da zadrži važne informacije tokom mnogo koraka obrade, rešavajući problem Nestajućih gradijenata mnogo uspešnije nego standardni RNN.

Zašto je Mehanizm pažnje ipak pobedio?

Iako je LSTM rešio problem dugoročnog pamćenja, i RNN i LSTM imali su kritičnu manu u pogledu efikasnosti:

- Sekvencijalnost (problem paralelizacije): Oba modela moraju da obrade token t-1 da bi mogli da obrađuju token t. To znači da se obrada ne može raditi na modernim GPU-ovima, jer su oni dizajnirani za paralelne operacije.

- Ograničena pažnja: Čak i LSTM, iako poboljšan, i dalje je morao da "prosledi" sve informacije kroz jednu "cevčicu" (stanje ćelije), dok Mehanizam pažnje omogućava modelu da direktno pristupi bilo kojoj relevantnoj informaciji u celom nizu istovremeno.

Zaključak: RNN i LSTM su bili neophodni evolucijski koraci koji su nas doveli do mogućnosti obrade teksta. Međutim, tek sa arhitekturom Transformer i Mehanizmom pažnje koji omogućava paralelizaciju i direktnu, ciljanu povezanost reči, postalo je moguće stvarati današnje ultra-velike i brze AI modele (LLM).

Tagovi: #AI #RNN #LSTM

Komentari

Nema komentara. Šta vi mislite o ovome?