Upravljanje lokalnim AI modelima putem Dockera

Dobrodošli u svet suverene veštačke inteligencije. Kao arhitekta AI rešenja, cilj mi je da vam pokažem kako da kompleksne DevOps tokove transformišete u stabilnu lokalnu infrastrukturu. Ovaj priručnik će vas naučiti kako da koristite Docker za pokretanje moćnih modela direktno na vašoj mašini, pružajući vam privatnost i performanse bez oslanjanja na eksterne Cloud provajdere.

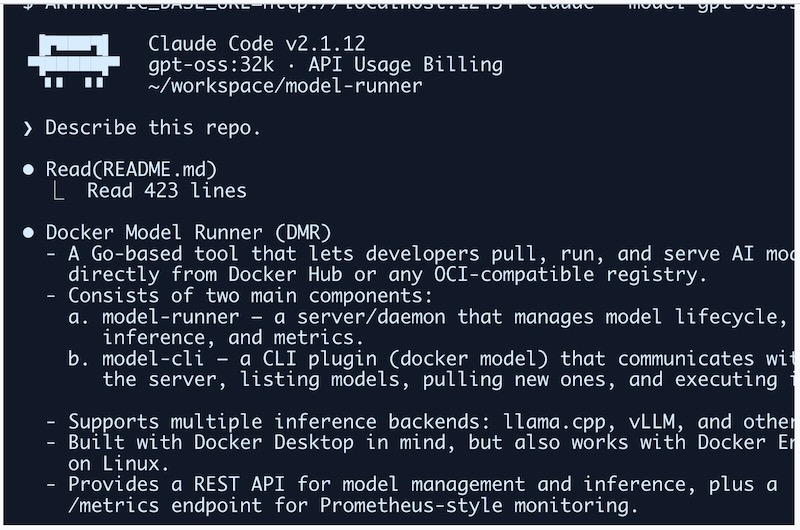

1. Uvod u lokalni AI ekosistem sa Docker Model Runnerom

Docker Model Runner (DMR) je specijalizovani alat koji omogućava programerima da povlače, pokreću i upravljaju velikim jezičkim modelima (LLM) na sopstvenom hardveru. DMR nije samo "wrapper" (omotač); on podržava napredne backende za zaključivanje kao što su llama.cpp i vLLM, čineći ga robusnim rešenjem za lokalni razvoj AI agenata poput Claude Codea.

Sistem se sastoji iz dve ključne komponente:

- model-runner (server): Pozadinski proces (daemon) koji upravlja životnim ciklusom modela, procesom zaključivanja i metrikama. On služi kao lokalni API gateway.

- model-cli (plugin): Komandni alat (

docker model) koji koristite za interakciju sa serverom direktno iz vašeg terminala.

Ključne prednosti lokalne AI infrastrukture:

- Apsolutna privatnost: Vaš izvorni kod, struktura projekta i upiti nikada ne napuštaju vašu lokalnu mrežu.

- Eliminacija troškova: Zaboravite na mesečne pretplate i naplatu po tokenu; koristite resurse koje ste već kupili (svoj hardver).

- Offline rad: Vaš AI asistent je dostupan čak i kada niste povezani na internet, što je kritično za rad u bezbednim ili izolovanim okruženjima.

Pre nego što počnemo sa manipulacijom modelima, moramo pravilno konfigurisati Docker okruženje kako bi ono postalo vidljivo vašim alatima.

2. Priprema radnog okruženja: Docker Desktop i Mrežni Pristup

Da bi spoljni alati (poput Claude Code terminalskog klijenta) mogli da komuniciraju sa Docker Model Runner-om, neophodno je omogućiti TCP pristup. Ovo efektivno pretvara vaš Docker instance u lokalni API server kompatibilan sa industrijskim standardima.

Izvršite sledeću komandu u vašem terminalu da biste aktivirali Model Runner:

docker desktop enable model-runner --tcpNakon aktivacije, DMR postaje dostupan na standardnom portu 12434. U tabeli ispod su detalji vašeg lokalnog endpoint-a:

| Parametar | Vrednost |

|---|---|

| Lokalni API URL | http://localhost:12434 |

| Podrazumevani Port | 12434 |

| Protokol | TCP / HTTP |

Aktivacijom servera postavili smo temelje; sledeći korak je nabavka i optimizacija samih modela.

3. Upravljanje životnim ciklusom modela: Pull i Package

Rad sa modelima prati logiku sličnu radu sa Docker slikama (images). Prvo povlačimo model sa registra, a zatim ga "pakujemo" (repackaging) kako bismo kreirali novu, optimizovanu lokalnu verziju prilagođenu specifičnim zadacima.

Proces od dva koraka:

- Pull: Preuzimanje osnovnog modela iz registra (npr.

gpt-oss). Napomena: Model se nalazi uai/namespace-u. - Package: Kreiranje nove slike modela sa prilagođenim parametrima.

Zašto je "Context Size" važan za programere? Veličina konteksta predstavlja "radnu memoriju" modela. Za kodiranje, 4,096 tokena je često nedovoljno jer model mora istovremeno da vidi vaše stablo fajlova, sadržaj trenutnog fajla i prethodnu istoriju četa. Ako je kontekst premali, model će "zaboraviti" početak fajla dok dođe do kraja.

| Karakteristika | Podrazumevani gpt-oss |

Optimizovani gpt-oss:32k |

|---|---|---|

| Veličina konteksta | 4.096 tokena | 32.000 tokena |

| Primena | Kratki upiti i objašnjenja | Analiza celih modula i refaktorisanje |

Arhitektonski savet: Ako želite da preskočite korak pakovanja, modeli kao što su _qwen3-coder_ ili _glm-4.7-flash_ dolaze sa 128k konteksta po defaultu.

Izvršite sledeće komande za pripremu vašeg optimizovanog modela:

# 1. Povlačenje osnovnog modela (korišćenjem punog naziva slike)

docker model pull gpt-oss2. Pakovanje nove lokalne slike sa proširenom memorijom

docker model package --from ai/gpt-oss --context-size 32000 gpt-oss:32k

4. Integracija sa Claude Code alatkom

Claude Code je dizajniran da komunicira sa Anthropic Cloud API-jem, ali zahvaljujući Docker Model Runner-u, možemo ga preusmeriti na lokalnu mašinu. Ovo funkcioniše jer DMR server verno oponaša Anthropic API strukturu. Ključ je u varijabli okruženja ANTHROPIC_BASE_URL.

Privremeno pokretanje (za testiranje):

ANTHROPIC_BASE_URL=http://localhost:12434 claude --model gpt-oss:32k

"Objasni ovaj repozitorijum."Perzistentnost (Trajna podešavanja)

Da ne biste ručno postavljali URL svaki put, dodajte export naredbu u vašu shell konfiguraciju.

Za Zsh (podrazumevano na macOS-u):

echo 'export ANTHROPIC_BASE_URL=http://localhost:12434' >> ~/.zshrc

source ~/.zshrcZa Bash (podrazumevano na većini Linux distribucija):

echo 'export ANTHROPIC_BASE_URL=http://localhost:12434' >> ~/.bashrc

source ~/.bashrcSada možete jednostavno kucati claude i alat će automatski koristiti vaš lokalni Docker Model Runner.

5. Monitoring i verifikacija upita

Kao inženjeru, neophodna vam je transparentnost. Docker Model Runner vam omogućava da presretnete i analizirate svaki bajt koji Claude Code šalje lokalnom modelu.

Uloga alata **jq** u debugovanju: Komanda docker model requests pruža sirove podatke o saobraćaju. Korišćenjem alata jq, ove podatke pretvarate u pregledan JSON format. Ako nemate jq, instalirajte ga putem:

- macOS:

brew install jq - Ubuntu/Debian:

sudo apt install jq

Za praćenje upita u realnom vremenu koristite:

docker model requests --model gpt-oss:32k | jq .Ovo vam omogućava da vidite tačne "system prompt-ove" koje Claude koristi, što je neprocenjivo za razumevanje kako agent donosi odluke o vašem kodu.

6. Rezime i kontrolna lista za uspeh

Uspešno ste konfigurisali lokalni AI stack koji je privatan, besplatan i potpuno pod vašom kontrolom. Prođite kroz ovu listu kako biste potvrdili da je sve ispravno postavljeno:

- [ ] Setup: Docker Desktop je aktivan i Model Runner TCP pristup je omogućen.

- [ ] Infrastruktura: Port

12434je otvoren i dostupan na localhost-u. - [ ] Model: Osnovni model je povučen, a verzija sa većim kontekstom (npr.

32k) je spakovana. - [ ] Povezivanje:

ANTHROPIC_BASE_URLje dodat u vaš.zshrcili.bashrc. - [ ] Verifikacija: Komanda

docker model requestsprikazuje dolazne zahteve bez grešaka.

Zaključna misao: Preuzeli ste kontrolu nad sopstvenom AI infrastrukturom. Vaš kod sada ostaje tamo gde i pripada – kod vas – dok istovremeno uživate u najsavremenijim mogućnostima AI asistiranog programiranja. Srećno kodiranje!

Izvor: docker.com

Komentari

Nema komentara. Šta vi mislite o ovome?