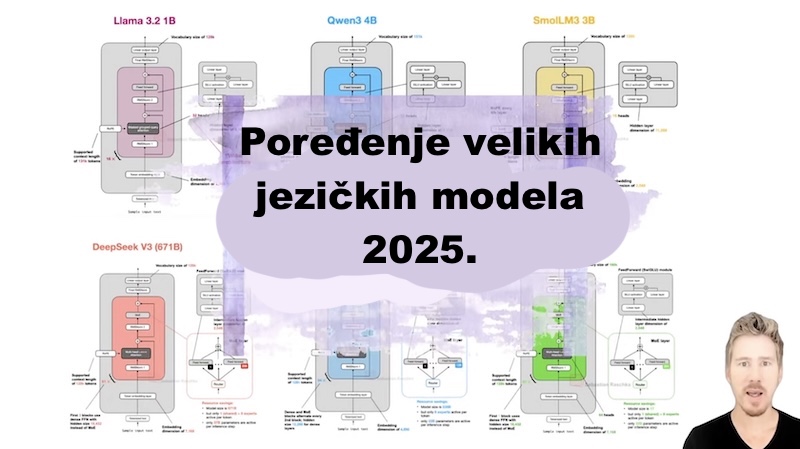

Analiza ključnih jezičkih modela objavljenih 2024. i 2025. godine otkriva da, iako fundamentalna Transformer arhitektura ostaje osnova, došlo je do značajne evolucije u ključnim komponentama. Tri dominantna trenda definišu trenutno stanje razvoja: 1. uspon Mixture-of-Experts (MoE) arhitektura, 2. potraga za efikasnijim mehanizmima pažnje i 3. oživljavanje linearne pažnje za obradu ekstremno dugih konteksta.